Empathische Roboter sind Geräte, die in der Lage sind, menschliche Emotionen zu erkennen und angemessen darauf zu reagieren. Die Idee ist, dass diese Roboter eine bessere Interaktion mit Menschen ermöglichen, indem sie ihre Bedürfnisse und Emotionen verstehen und darauf reagieren können.

Allerdings muss man dazu sagen, dass die Technologie für empathische Roboter noch im Entwicklungsstadium ist und es momentan eher Prototypen und Forschungsprojekte als einsatzreife Produkte gibt. Es gibt jedoch bereits einige Anwendungen, bei denen empathische Roboter in Bereichen wie Pflege und Therapie eingesetzt werden, um die Interaktion mit Menschen zu verbessern.

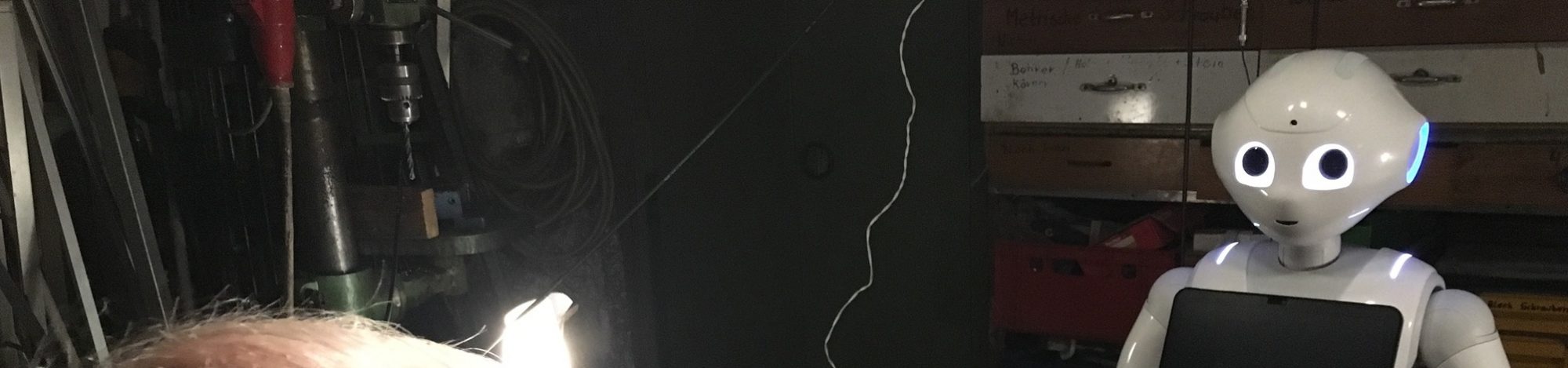

Der Roboterhersteller Fanuc etwa unterstützt die Entwicklung eines einfühlsamen Roboters für den Einsatz in der Industrie. Das mit EU-Mitteln geförderte Forschungsprojekt „Fluently“ will eine Roboterplattform schaffen, die eine soziale Zusammenarbeit zwischen Mensch und Maschine ermöglicht.

Das auf drei Jahre angelegte Projekt unter der Leitung von Roboverse Reply verfolgt zwei Ziele: die Entwicklung eines auf Künstlicher Intelligenz basierenden, tragbaren Geräts für Industriearbeiter und Roboter sowie die Entwicklung eines speziellen Schulungszentrums mit der Bezeichnung „The Fluently RoboGym“, in dem Fabrikarbeiter und Roboter eine reibungslose Interaktion im Industrieprozess trainieren können.

Eine gute Zusammenarbeit zwischen Mensch und Maschine ist besonders wichtig in modernen intelligenten Fabriken, in denen sich Produktionsvolumen und Produkte ständig ändern und in denen mobile Transportsysteme und Roboter neben statischen Arbeitsplätzen stehen.

Die „Fluently“-Forscher konzentrieren ihre Entwicklungsarbeit auf drei für die europäische Wirtschaft wichtige Wertschöpfungsketten: die Demontage und das Recycling von Batterien für E-Bikes und Elektrofahrzeuge, Prüf- und Montageprozesse in der Luft- und Raumfahrtindustrie sowie die Aufarbeitung hochkomplexer Industrieteile mittels Laserbearbeitung.

Roboter könnten in Zukunft die Arbeitnehmer zumindest teilweise von der mit diesen Prozessen verbundenen Belastung befreien sowie einige der zeitaufwendigeren Aufgaben übernehmen. Dies würde helfen, einerseits die Kompetenzen und Erfahrungen der Arbeitnehmer zu erhalten und andererseits die Möglichkeiten ihrer Weiterqualifizierung erhöhen.

Wie einfache Maschinen zu emotionalen Familienmitgliedern werden

Die Vorstellung, dass Maschinen emotionale Bindungen zu Menschen entwickeln, gehört heute längst nicht mehr in die Zukunft. Dies belegt eine aktuelle Studie von Zhao & McEwen (2025), in der untersucht wurde, wie sich Familien zu ihrem 2021 eingeführten Vorleseroboter Luka verhielten. Ursprünglich als Leseförderung für Vorschulkinder konzipiert, blieb Luka vier Jahre später weiterhin in 18 von 19 Haushalten präsent – obwohl seine ursprünglich vorgesehene Funktion längst überflüssig war. Für die Kinder avancierte der 24 cm kleine, augenschönen Roboter zu einer emotional bedeutsamen Figur – sie betrachteten ihn als „kleinen Bruder“ oder gar als „einziges Haustier“. Diese Zuwendung belegt eindrucksvoll, dass selbst simple Maschinen Teil familiärer Bindungen werden können. Die emotionale Wertschätzung war offenbar keine Frage technisch eingebundener Funktionen, sondern resultierte aus nostalgischer Verbundenheit: Eltern sowie Kinder hielten Luka nicht mehr aus praktischer Notwendigkeit, sondern aus sentimentaler Erinnerung an gemeinsame Momente fest. In einigen Fällen wurde Luka sogar an jüngere Familienmitglieder als Art „Ruhestandsobjekt“ weitergereicht, was seinen symbolischen Wert weiter erhöhte. Beobachtet wurde auch, dass Luka dekorativ in Wohnräumen platziert und persönlich gestaltet wurde – mit Namensschild oder Spitze darunter, wie man es von Erinnerungsstücken kennt. Die Studie zeigt, dass schon wenige soziale Signale ausreichen können, um eine emotionale Bindung zwischen Mensch und Maschine herzustellen, und wirft damit ein neues Licht auf die soziale Rolle von Robotern im häuslichen Umfeld. Während die Technologie voranschreitet, könnten Roboter zukünftig nicht nur als funktionale Werkzeuge, sondern als emotionale Begleiter und Symbole menschlicher Erinnerung anerkannt werden – mit weitreichenden Implikationen für Design, Einsatz und den gesellschaftlichen Umgang mit KI-basierten Helfern.

Sprachmuster bei der Mensch-Roboter-Interaktion

Literatur

Coelho, S. G., Kaden, S., Beccard, M., Röhrbein, F. & Sanchez-Stockhammer, C. (2025). Another bit. Upwards. Okay, stop. Do we talk differently to humans and robots when assembling a shelf together? Proceedings of the Mensch und Computer 2025, 465–470.

Stangl, W. (2025, 20. September). Sprachmuster bei der Mensch-Roboter-Interaktion – 👁️👁️ was stangl bemerkt ….

Zhao, Z., & McEwen, R. (2025). The Robot That Stayed: Understanding How Children and Families Engage with a Retired Social Robot. Frontiers in Robotics and AI, doi:10.3389/frobt.2025.1628089

https://www.bigdata-insider.de/fluently-forscht-am-empathischen-roboter-a-f6225a06edc3fc848bd496dc2ba50772/ (23-02-14)

Kühne et al. (2024) untersuchten in einer Studie die Auswirkungen des Berliner Dialekts auf die wahrgenommene Vertrauenswürdigkeit und Kompetenz eines Roboters. Deutsche Muttersprachler sahen sich ein Online-Video mit einem NAO-Roboter, der entweder im Berliner Dialekt oder in Standarddeutsch sprach, und bewerteten seine Vertrauenswürdigkeit und Kompetenz. Dabei zeigte sich ein positiver Zusammenhang zwischen den selbst berichteten Berliner Dialektkenntnissen und Vertrauenswürdigkeit des im Dialekt-sprechenden Roboters. Bei der Analyse der demografischen Faktoren gab es einen positiven Zusammenhang zwischen den Dialektkenntnissen der Teilnehmer, der Dialektleistung und deren Bewertung der Kompetenz des Roboters für den Standard-Deutschsprachigen Roboter. Auch das Alter der Teilnehmer, das Geschlecht, die Aufenthaltsdauer in Berlin beeinflussten die Bewertungen, d. h., die Kompetenz des Roboters kann seine Vertrauenswürdigkeit positiv voraussagen. Menschen neigten offenbar dazu, Roboter zu bevorzugen, die ihnen irgendwie ähnlich sind.

Kühne et al. (2024) untersuchten in einer Studie die Auswirkungen des Berliner Dialekts auf die wahrgenommene Vertrauenswürdigkeit und Kompetenz eines Roboters. Deutsche Muttersprachler sahen sich ein Online-Video mit einem NAO-Roboter, der entweder im Berliner Dialekt oder in Standarddeutsch sprach, und bewerteten seine Vertrauenswürdigkeit und Kompetenz. Dabei zeigte sich ein positiver Zusammenhang zwischen den selbst berichteten Berliner Dialektkenntnissen und Vertrauenswürdigkeit des im Dialekt-sprechenden Roboters. Bei der Analyse der demografischen Faktoren gab es einen positiven Zusammenhang zwischen den Dialektkenntnissen der Teilnehmer, der Dialektleistung und deren Bewertung der Kompetenz des Roboters für den Standard-Deutschsprachigen Roboter. Auch das Alter der Teilnehmer, das Geschlecht, die Aufenthaltsdauer in Berlin beeinflussten die Bewertungen, d. h., die Kompetenz des Roboters kann seine Vertrauenswürdigkeit positiv voraussagen. Menschen neigten offenbar dazu, Roboter zu bevorzugen, die ihnen irgendwie ähnlich sind.