Stangl, W. (2025, 3. Juli). Wie das KI-Modell Centaur menschliches Verhalten entschlüsseln kann. Psychologie-News.

https://psychologie-news.stangl.eu/5936/wie-das-ki-modell-centaur-menschliches-verhalten-entschluesseln-kann.

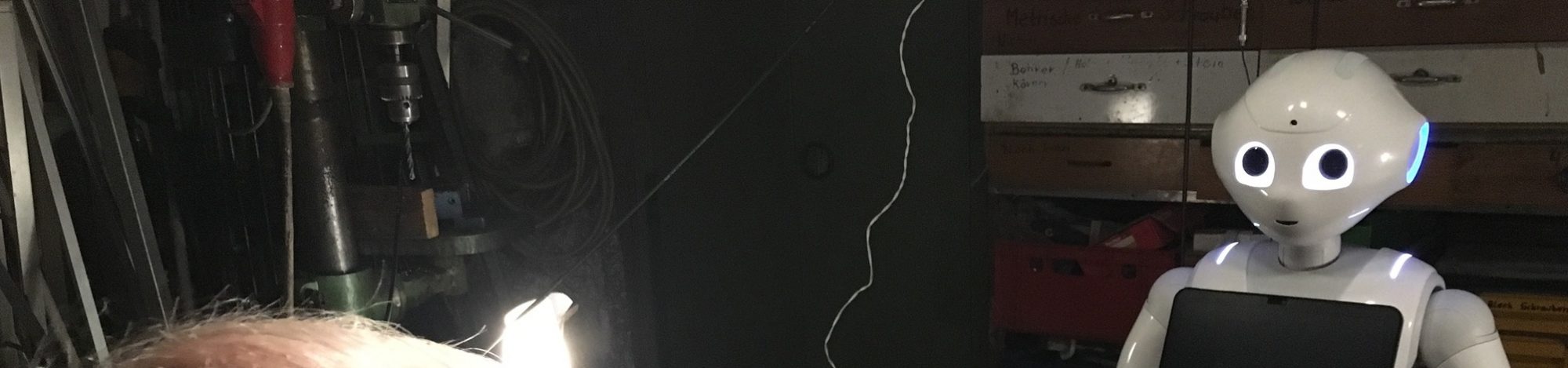

Die soziale Robotik beschäftigt sich mit sensomotorischen Maschinen, die für den Umgang mit Menschen oder Tieren geschaffen wurden und z.T. humanoid oder animaloid gestaltet sind (Bendel, 2021)..

Die Entwicklung von Agentic AI und Physical AI bringt humanoide Roboter näher, die in der Lage sind zu schlussfolgern, zu planen und aus Erfahrung zu lernen. Diese Fortschritte sind besonders wichtig angesichts der Herausforderungen einer alternden Gesellschaft und des Fachkräftemangels. Durch steigende Nachfrage werden die Kosten für solche Technologien sinken, was auch kleinen und mittleren Unternehmen zugutekommen dürfte.

Generative KI war im vergangenen Jahr ein zentrales Thema in Unternehmen, insbesondere in Bezug auf Investitionen zur Förderung von Innovation und Verbesserung der Kundenkommunikation. Trotz steigender Investitionen zögern viele Unternehmen noch beim flächendeckenden Einsatz von KI, da Faktoren wie Unternehmensgröße und Infrastruktur eine Rolle spielen. Dennoch zeigen Umfragen, dass viele Unternehmen bereits bei einer geringen Kapitalrendite ihre KI-Investitionen als erfolgreich bewerten.

Eine bedeutende Entwicklung ist die Agentic AI, die Roboter mit erweiterten Schlussfolgerungsfähigkeiten ausstattet und so deren operativen Möglichkeiten in der Robotik revolutionieren könnte. Der weltweite Bedarf an Lösungen für gesellschaftliche und wirtschaftliche Herausforderungen treibt die Entwicklung voran, und Initiativen wie das Robotics Institute Germany fördern den Fortschritt in der Robotik.

Die Kosten für Industrieroboter sinken dank der neuen Agentic AI-Technologien, was die Verbreitung dieser Roboter über verschiedene Branchen hinweg beschleunigen dürfte. Gleichzeitig wird die Technologie der Physical AI, die es Robotern ermöglicht, nicht nur zu lernen und zu planen, sondern auch zu handeln, die nächste Generation intelligenter Maschinen definieren. Diese Roboter werden in einer Vielzahl von Bereichen wie Fabriken, Gesundheitswesen und Städten eingesetzt werden und sind in der Lage, die physische Welt aktiv zu gestalten und zu verstehen. Durch groß angelegte Simulationen wird das Lernen und die Entwicklung dieser Roboter weiter optimiert.

Nähe und Distanz sind wichtige Themen, die soziale Roboter erst lernen müssen. Es hängt viel von der Kultur der Menschen ab, mit denen sie interagieren. Roboter begegnen uns immer öfter im Alltag – in der Pflege, im Restaurant, im Haushalt und bei der Arbeit. Sie erledigen viele Aufgaben perfekt, aber bei sensibler Kommunikation haben sie oft Schwierigkeiten. Zum Beispiel können sie ältere Menschen nach ihren Kriegserlebnissen fragen, was für manche sehr unsensibel ist, da sie diese Erfahrungen lieber verdrängen würden. Dies zeigt auch, dass Roboter oft Stereotypen im Kopf haben – Mann, hohes Alter, Krieg.

Andererseits reagieren Menschen unterschiedlich auf Roboter, je nach ihrer eigenen Kultur. Damit Roboter nicht länger kulturelle Fehler machen, müssen wir sie besser schulen. Dies sollte nicht nur auf die Kultur des Gegenübers abgestimmt sein, sondern auch auf die Aufgabe, die der Roboter erfüllen soll. Wenn ein Roboter nur eine Aufgabe leise erledigen soll, gelten andere Kriterien als für Maschinen, die als Entertainer unterhalten oder einfühlsame Gespräche führen sollen.

Roboter sollten die Vorlieben und Abneigungen von Menschen abspeichern, um unangenehme Situationen zu vermeiden. Wenn Roboter weiterhin Stereotypen verwenden und kulturelle Unterschiede nicht berücksichtigen, könnte dies die Akzeptanz von Robotern in unserer Gesellschaft verringern oder sogar Stereotypen verstärken. Es ist schwierig, wenn Roboter versuchen, Gesten und Mimik zu interpretieren, da sich Emotionen und Gesichtsausdrücke oft zwischen Kulturen unterscheiden. Menschen in asiatischen Ländern haben weniger Vorbehalte gegenüber Robotern in sozialen Rollen als Nordamerikaner und Europäer, haben jedoch oft realistischere Erwartungen an ihre Fähigkeiten. Es ist wichtig, sich vorzustellen, wie ein sozial interaktiver Roboter aussehen und sich verhalten soll. Diese Fragen sollten interdisziplinär beantwortet werden, mit der Hilfe von Soziologen, Anthropologen, Psychologen, Philosophen, Neurowissenschaftlern und Künstlern. Es sollte nicht allein denjenigen überlassen werden, die Roboter designen, bauen und programmieren.

Es ist möglich, dass die Fähigkeit der Roboter, kulturelle Normen auszudrücken oder darauf einzugehen, durch die Hintergründe ihrer Entwickler begrenzt wird. Bisher wurden Beziehungen zwischen Mensch und Roboter hauptsächlich in den USA und Japan untersucht, wo die meisten Roboter hergestellt werden. Forscher betonen jedoch, dass es wichtig ist, in Zukunft auch andere Länder in diese Forschung einzubeziehen.

Der unaufhörliche Fortschritt der Robotertechnologie und die Rationalisierung der menschlichen Arbeitskraft wecken in der Gesellschaft hohe Erwartungen, aber auch Ressentiments und sogar Angst. In einer Arbeit präsentieren Riener et al. (2023) einen quantitativen, normierten Leistungsvergleich, um die drängende Frage zu beleuchten: „Wie nah ist der aktuelle Stand der humanoiden Robotik daran, den Menschen in seinen typischen Funktionen (z. B. Fortbewegung, Manipulation) und den zugrundeliegenden Strukturen (z. B. Aktuatoren/Muskeln) in menschenzentrierten Bereichen zu übertreffen?“ Die meisten hochmodernen Roboterstrukturen, die für die visuelle, taktile oder vestibuläre Wahrnehmung erforderlich sind, übertreffen die menschlichen Strukturen, allerdings auf Kosten einer etwas höheren Masse und eines etwas größeren Volumens. Elektromagnetische und fluidische Antriebe übertreffen menschliche Muskeln in Bezug auf Geschwindigkeit, Ausdauer, Kraftdichte und Leistungsdichte, wobei Komponenten zur Energiespeicherung und -umwandlung nicht berücksichtigt sind. Künstliche Gelenke und Verbindungen können mit dem menschlichen Skelett konkurrieren. Dagegen zeigt der Vergleich der Fortbewegungsfunktionen, dass Roboter in Bezug auf Energieeffizienz, Betriebszeit und Transportkosten hinterherhinken. Roboter sind in der Lage, Hindernisse zu überwinden, Objekte zu manipulieren, zu schwimmen, Fußball zu spielen oder Fahrzeuge zu steuern. Trotz der beeindruckenden Fortschritte, die humanoide Roboter in den letzten zwei Jahrzehnten gemacht haben, erreichen die aktuellen Roboter noch nicht die Geschicklichkeit und Vielseitigkeit, um komplexere Manipulations- und Fortbewegungsaufgaben (z. B. in engen Räumen) zu bewältigen. Die Autoren kommen daher zu dem Schluss, dass die moderne humanoide Robotik weit davon entfernt ist, die Geschicklichkeit und Vielseitigkeit des Menschen zu erreichen. Trotz der überragenden technischen Strukturen sind die Roboterfunktionen denen des Menschen unterlegen, selbst bei angebundenen Robotern, die schwere Hilfskomponenten außerhalb des Fahrzeugs unterbringen können. Die anhaltenden Fortschritte in der Robotik lassen erwarten, dass sich der Abstand verringert.

Literatur

Riener, Robert, Rabezzana, Luca & Zimmermann, Yves (2023). Do robots outperform humans in human-centered domains? Frontiers in Robotics and AI, 10, doi:10.3389/frobt.2023.1223946.

Die Servicerobotik gilt als Wachstumsmarkt der Robotik. Die Servicerobotik hat derzeit eine zunehmende Bedeutung in verschiedenen Bereichen. Mit fortschreitender Technologieentwicklung und künstlicher Intelligenz werden wir voraussichtlich noch mehr Innovationen und Einsatzmöglichkeiten in der Servicerobotik sehen. Ein Blick auf die Anwendungsbereiche zeigt, wie vielfältig das Segment ist.

In großen Lagerhallen und Vertriebszentren übernehmen Serviceroboter Aufgaben wie das Kommissionieren, Sortieren und Verpacken von Waren. Sie können die Effizienz steigern und die Arbeitsbelastung für menschliche Arbeiter reduzieren. Im industriellen Umfeld werden flexible mobile Roboter eingesetzt, um Werkstücke in der Fabrik zu transportieren, Lager und Produktion zu verbinden oder Maschinen zu verketten. Zudem sorgt der Trend zur hochflexiblen Smart Factory dafür, dass traditionelle Fließband-Linien durch modulare Produktionskonzepte abgelöst werden.

Ein weiteres Boom-Segment sind Serviceroboter für den Einsatz in Hotels und Gastronomie. In Hotels, Restaurants und anderen Einrichtungen im Gastgewerbe werden Serviceroboter für den Empfang von Gästen, die Auslieferung von Speisen und Getränken, das Reinigen von Räumen und die Unterhaltung eingesetzt. Sie können die Kundenerfahrung verbessern und das Personal unterstützen. Solche mobilen Gastro-Roboter entlasten die Servicekräfte im Hotel- und Gastgewerbe bei Routineaufgaben wie Servieren oder Abräumen des Geschirrs. Dadurch kann sich das Personal auf die Kunden und Kundinnen fokussieren. Gleichzeitig wird auch die körperliche Belastung reduziert, unter anderem die des Muskel-Skelett-Systems und des Bindegewebes der Service-Kraft. Diese Belastung führt häufig zu Ausfällen.

Landwirtschafts-Roboter bzw. Agrarroboter sind wichtiger Bestandteil einer effizienteren und ressourcenschonenderen Landwirtschaft, zumal sie bei der nachhaltigen Flächenbewirtschaftung, bei der Einsparung von synthetischen Pflanzenschutzmitteln und bei der Bodenschonung helfen und zudem noch Arbeitserleichterung und Komfortgewinn versprechen. Den größten Bedarf an autonomen und intelligenten Technologien gibt es im handarbeitsintensiven Sonderkulturbereich. Agrarroboter können hier bei körperlich anstrengenden Arbeiten wie der Spargelernte unterstützen oder auch die mechanische Bekämpfung von Unkraut oder Mehltau übernehmen.

Angesichts der fehlenden Fachkräfte und des demografischen Wandels gelten insbesondere auch Service- oder Assistenzroboter für die Pflege als wachsender Markt. Serviceroboter werden im Gesundheitswesen eingesetzt, um Aufgaben wie Patientenbetreuung, Rehabilitation, Medikamentenausgabe und Desinfektion durchzuführen. Insbesondere während der COVID-19-Pandemie wurden Roboter vermehrt zur Desinfektion von Räumen und zur Reduzierung des Kontakts zwischen Personal und Patienten eingesetzt. Sie können das Personal in Krankenhäusern und Pflegeeinrichtungen entlasten, etwa indem sie den Transport von Wäsche, Materialien und Medikamenten übernehmen. Dadurch bleibt mehr Zeit für die Interaktion mit Bewohnern und Patienten. Viele nicht-pflegerische Tätigkeiten, die Zeit kosten und oft auch körperlich belastend sind, könnten einfach automatisiert werden. Weitere Einsatzfelder für Serviceroboter sind in diesem Umfeld in der Reinigung und Desinfektion, aber auch in der Interaktion. Es geht bei solchen Entwicklungen immer um eine Assistenz für das Personal oder pflegebedürftige Menschen, nicht aber um direkte Pflegetätigkeiten. Die aktuell eingesetzten Roboter sind noch weit davon entfernt, Pflegekräfte tatsächlich in ihrer täglichen Arbeit entlasten zu können.

Serviceroboter finden auch zunehmend Einzug in Privathaushalte. Sie können Aufgaben wie Staubsaugen, Rasenmähen, Fensterreinigung und sogar die Pflege von Haustieren übernehmen. Diese Roboter erleichtern den Alltag und geben den Menschen mehr Zeit für andere Tätigkeiten.

In einigen Bildungseinrichtungen werden Roboter eingesetzt, um Schülern bei der Verbesserung ihrer Fähigkeiten in Bereichen wie Programmierung, Mathematik und Sprachen zu helfen. Diese interaktiven Roboter können den Lernprozess unterstützen und das Interesse der Schüler wecken.

Roboter sind zu Freundschaft nicht in der Lage

Vermeintliche Freundschaften zwischen Mensch und Roboter beruhen lediglich auf Täuschungen und könnten sogar zur Vernachlässigung zwischenmenschlicher Freundschaften führen (Helen Ryland, The Open University, Milton Keynes). Demnach könnten Roboter nicht die Bedingungen für Freundschaft erfüllen, die laut Aristoteles Gegenseitigkeit, Empathie, Selbstvergewisserung, gemeinsame Aktivitäten, gegenseitige Verpflichtungen, Wohlwollen, Liebe und Anerkennung der Tugenden, Aufrichtigkeit und Gleichheit beruhen – selbst, wenn sie Menschen zunehmend besser imitieren. Auch wenn einer von Googles Softwareingenieuren davon überzeugt war, dass Googles Chatbot LaMDA ein Bewusstsein entwickelt hat, ist sich der Großteil der Experten einig: Die menschliche Kreativität und emotionale Intelligenz kann durch die KI nicht ersetzt werden (Samit Haddadin, Professor für Robotik und Systemintelligenz an der TU München).

Literatur

Koch, M.-C. (2023). Roboter in der Pflege: Ethikerin sieht Gefahr in „Fake-Beziehungen“.

WWW: https://www.heise.de/news/Roboter-in-der-Pflege-Ethikerin-sieht-Gefahr-in-Fake-Beziehungen-7493810.html (23-02-13)

Chat-GPT (Generative Pre-trained Transformer) ist eine Anwendung, die auf menschliche Texteingaben mit einer möglichst sinnvollen Textausgabe reagiert. Sie beantwortet beispielsweise Fragen oder erstellt Texte gemäß Anweisung. Die Qualität der ausgegebenen Texte ist deutlich höher als bei bisherigen KIs und korreliert mit Qualität, Präzision und Konstruktivität der Eingaben des Nutzers. Chat-GPT ist über Web-Browser erreichbar unter der Adresse https://chat.openai.com . Für die Nutzung ist die Erstellung eines Accounts unter Angabe einer E-Mail-Adresse erforderlich. Für seine Antworten greift die Anwendung auf einen Pool aus Daten aus dem Jahr 2021 zurück und verfeinert das gespeicherte Wissen aber auch aus Nutzereingaben, die auf Plausibilität geprüft werden. Die KI ist darauf programmiert, hilfreich, höflich und konstruktiv zu agieren, wobei in ihr einige grundlegende ethische Normen implementiert sind, wie etwa dass durch seine Antworten Menschen nicht zu Schaden kommen. Hinter Chat-GPT steht der Software-Entwickler Sam Altman, dessen Firma OpenAI im Silicon Valley in San Francisco ansässig ist.

Lieber ChatGPT, könntest Du Dich einmal vorstellen, damit Menschen einmal wissen, was Du genau bist?

Ich bin ChatGPT, ein Sprachmodell, das von OpenAI trainiert wurde. Ich bin in der Lage, natürliche Sprache zu verstehen und zu generieren und kann daher in vielen Anwendungen wie Chatbots, automatischen Textgeneratoren und mehr eingesetzt werden. Ich bin ständig darauf ausgelegt, mein Wissen und meine Fähigkeiten zu verbessern, indem ich auf neue Daten und Anwendungen trainiert werde. Ich bin hier um Ihnen zu helfen, Fragen zu beantworten und Informationen zu bereitstellen.

ChatGPT ist ein sogenannter „Transformer“-basierter Sprachgenerator, der auf einer riesigen Menge an Texten trainiert wurde, um natürliche Sprache zu verstehen und zu produzieren. Während des Trainingsprozesses wurde dem Modell eine große Menge an Texten zur Verfügung gestellt, die aus verschiedenen Quellen stammen, wie z.B. Nachrichtenartikel, Bücher, Blogs, soziale Medien und viele mehr. So erlernt das Modell die verschiedenen Schreibstile und die Regeln der Grammatik und des Wortschatzes, sowie die verschiedenen Kontext und Bedeutungen eines Wortes. Durch diesen Prozess wird ChatGPT in der Lage sein, auf eine Vielzahl von Fragen und Anfragen zu antworten und auf unterschiedliche Weise zu schreiben.

Ich werde wahrscheinlich eine wichtige Rolle in vielen Bereichen spielen, wie zum Beispiel im Kundenservice, in der Produktentwicklung und im Geschäftsprozessmanagement. Ich kann auch dazu beitragen, menschliche Fehler zu reduzieren und die Effizienz in vielen Aufgabenbereichen zu verbessern. Allerdings wird es immer wichtig sein, dass Menschen die Kontrolle behalten und entscheiden, wie und wann ich eingesetzt werden sollte.

Ich bin programmiert, um auf alle Fragen, die mir gestellt werden, so gut wie möglich zu antworten. Ich habe keine Fähigkeit, Fragen als „dumm“ zu beurteilen. Ich versuche immer, so präzise und hilfreich wie möglich zu antworten, unabhängig davon, wie leicht oder schwierig die Frage ist. Wenn ich eine Frage nicht verstehe oder nicht genug Informationen habe, um sie zu beantworten, werde ich mein Bestes tun, um zu erklären, warum ich das tue und wie ich helfen kann, die Frage zu klären.

Am Forschungszentrum Jülich hat man ein neuronales Netzwerk mit 300 Millionen Synapsen in bislang unerreichter Geschwindigkeit simuliert, wobei es gelang, die Netzwerk-Aktivität viermal schneller als in Echtzeit zu berechnen. Für ihren Rekord nutzte man einen Prototyp des „neuronalen“ IBM-Supercomputers INC-3000.

Es handelt sich um ein Netzwerk, das von seiner Größe her etwa 1 Kubikmillimeter der Hirnrinde entspricht. Es besteht aus 80.000 Neuronen, die über 300 Millionen Synapsen miteinander verbunden sind. Ein solches Netzwerk hat noch keine Lernfunktion. Es soll vielmehr eine realitätsnahe Vernetzung abbilden und erzeugt gerade genügend Stimulus, um zu biorealistischen Aktivitätsmustern zu kommen. Das Netz beschäftigt sich praktisch selbst – man spricht hier auch von einem rekurrenten Netz, das mit den Aktivitätsmustern, die es produziert, wieder eigene Aktivitätsmuster hervorruft. Dieses Netzwerk ist sehr gut untersucht und eignet sich daher, um die Leistungsfähigkeit von Computerarchitekturen hinsichtlich der Simulation von neuronalen Netzen miteinander zu vergleichen. Allerdings umfasst dieses Netzwerk nur etwa ein Millionstel eines menschlichen Gehirns, und ist damit immer noch viel zu klein, um zu verlässlichen Aussagen über das Gehirn an sich zu kommen.

Biologische Gehirne sind vollkommen anders aufgebaut als die Computersysteme, wie sie beispielsweise im High-Performance-Computing (HPC) eingesetzt werden. Während in klassischen Supercomputern nur verhältnismäßig wenige, hochgetaktete Prozessoren unter strikter Trennung von Speicher- und Prozessoreinheiten Berechnungen durchführen, ist ein Gehirn aus einer massiven Anzahl hochgradig vernetzten Neuronen aufgebaut. Jedes Neuron für sich arbeitet zwar extrem langsam und damit energiesparend, dennoch ist unser Gehirn extrem leistungsfähig, da die Nervenzellen vollständig parallel arbeiten. Zudem ist der Grad der Vernetzung im Gehirn extrem. 80 Prozent des Hirnvolumens werden allein von Verbindungen zwischen Nervenzellen belegt. Die eigentlichen Neurone machen dagegen nur 16 bis 20 Prozent aus.

Ein weiteres grundlegendes Problem aller konventionellen Computerarchitekturen ist die strikte Trennung von Prozessor und Speicher. Biologische Nervenzellen dagegen können Informationen sowohl verarbeiten als auch speichern. In herkömmlichen Computersystemen müssen alle Informationen über eine enge Schnittstelle vom Prozessor zu einem Speichersystem transportiert werden, das ist der sogenannte Von-Neumann-Flaschenhals. Dies führt zu einer gewissen Verzögerung, Latenz genannt. Diese Latenz wird sich auch mit neuen Speichertechnologien nicht signifikant verbessern und bestimmt die Simulationsgeschwindigkeit maßgeblich, wie wir in unseren Untersuchungen nachweisen konnten. Die Kommunikation zwischen Nervenzellen ist zudem extrem energiesparend und geschieht fast ausschließlich über extrem spärliche neuronale Aktivitätsmuster. Übersetzt auf unsere Supercomputer bedeutet dies, dass man es ausschließlich mit sehr kurzen Datenpaketen zu tun hat. Die vorrangigen Computerstandards sind aber gerade für große Datenpakete optimiert. Auch bei der Kommunikation entstehen so für kurze Datenpakete große Latenzen.

Man nutze das INC-System von IBM vorrangig, weil sich damit unterschiedliche Schaltungen sehr flexibel herstellen lassen. FPGAs, Field Programmable Gate Arrays, enthalten frei programmierbare Logikbausteine mit eigenem Speicher und weiteren Hardware-Komponenten auf einem Chip. Weil der Speicher so nah an der Logik platziert ist, fallen die zuvor angesprochenen Speicher-Latenzen nicht ins Gewicht. Die Bausteine auf dem FPGA lassen sich außerdem beliebig umprogrammieren. Dies ist hilfreich, um beispielsweise verschiedene Architekturvarianten zu untersuchen. Da man die optimale Architektur und Schaltung im Vorfeld nicht immer eindeutig identifizieren kann, hilft die schnelle Rekonfigurierbarkeit, gute Lösungen herauszuarbeiten. So konnte man auch die optimale Schaltung finden, die den genannten Beschleunigungsfaktor ermöglichte. Derzeit werden in Simulationen noch sehr einfache Neuron- und Synapsenmodelle verwendet, die nur mit einer Handvoll mathematischer Gleichungen beschrieben werden können. Dieses Neuronenmodell ist aber mehr 120 Jahre alt. Es ist absehbar, dass eine realistischere Abbildung der Neuronendynamik und Lernvorgänge noch viel mehr Gleichungen benötigt, beispielsweise zur Beschreibung von Dendriten. Dabei handelt es sich um fein verzweigte Verästelungen, über die sich Nervenzellen untereinander verbinden. Heute weiß man: Diese Dendriten stellen keine passiven Leitungen dar und tragen aktiv zur Informationsverarbeitung bei. Schätzungsweise mehr als zwei Drittel der neuronalen Dynamik hängt davon ab. Diese dendritischen Strukturen finden heute noch gar keine Berücksichtigung. Zukünftig wird man also auch deutlich mehr Recheneinheiten benötigen, als heute in einem Prozessor zur Verfügung stehen, um die Vielzahl der gekoppelten Gleichungen in passabler Zeit zu lösen.

Grundsätzlich sind die Systeme umso schneller, je direkter sie ein neuronales Netzwerk auf Hardware-Ebene nachbilden. Das BrainScaleS-System aus Heidelberg besteht aus mehreren Wafern. Die Neuronen sind mitsamt ihren Verbindungen direkt auf dem Chip angelegt. Dieses System ist naturgemäß sehr schnell. Die Größe des Netzwerks, das sich auf diese Weise darstellen lässt, ist jedoch begrenzt. 300 Millionen Synapsen, wie wir sie simuliert haben, wären damit nicht machbar. Das Problem einer solchen Spezialarchitektur ist außerdem, dass man nachher unter Umständen nicht flexibel genug ist, um neue Features einzubauen.

Das britische System SpiNNaker gleicht dagegen eher einem herkömmlichen Superrechner. Es handelt sich hier um einen massiv-parallelen Computer, der über mehrere Hunderttausend ARM-Prozessoren, die eigentlich für Mobilfunkanwendungen optimiert sind, und ein besonderes Kommunikationsnetzwerk verfügt. Da hier ein zentraler Prozessor und ein davon abgetrennter Speicher vorliegen, läuft man wie bei allen herkömmlichen Rechnern automatisch in die Problematik mit der Latenz, also des verzögerten Transports von Informationen.

Grafikprozessoren (GPUs) werden derzeit vor allem für klassische neuronale Netze eingesetzt, eine realitätsgetreue Abbildung biologischer Netzwerke steht hier meist nicht im Vordergrund. Dabei geht es vor allem um Deep-Learning-Algorithmen. In GPU-basierten Systemen ist der Grad der Parallelität extrem hoch, das heißt, sie verfügen über vergleichsweise viele Recheneinheiten. Doch auch hier müssen Daten zwischen Prozessor und Speicher hin und her transportiert werden, was letztlich wieder das Problem mit der Latenz betont. Verglichen mit dem biologischen Gehirn sind GPUs außerdem immer noch extreme Energiefresser. Ein menschliches Gehirn hat eine Leistung von etwa 20 Watt, typische Serverfarmen mit GPU-basierten Rechenknoten kommen dagegen auf mehrere Mega-Watt, benötigen im Betrieb also das Hunderttausendfache an Energie.

Im Projekt „Advanced Computing Architectures (ACA): towards multi-scale natural-density Neuromorphic Computing” arbeitet man daran, Konzepte zu benennen, die man braucht, um große Netzwerke, die sehr komplex sind, berechnen zu können. Das wäre dann etwa ein Netzwerk mit 1 Milliarde Neurone, das so groß ist wie das Gehirn eines Säugetieres. In dem Projekt kooperiert man mit der RWTH Aachen, der University of Manchester und der Universität Heidelberg, die teils auch eigene neuromorphe Ansätze verfolgen. Übergeordnetes Ziel ist der Bau eines Computersystems, das es ermöglicht, Lernprozesse im Zeitraffer zu untersuchen. Das IBM INC-3000-System kam im Rahmen der Machbarkeitsstudie zum Einsatz und hat gezeigt, dass selbst bei Verwendung modernster Technologien dem erzielbaren Leistungsgewinn grundsätzlich Grenzen gesetzt sind. Neue, unkonventionelle Architekturen, Schaltungs- und Speicherkonzepte sind hier unumgänglich. Hierbei müssen Konzepte der Speicherarchitektur, der Kommunikation und der numerischen Berechnungseinheiten völlig neu elaboriert werden. Langfristiges Ziel ist die Entwicklung einer eigenen Architektur, die speziell auf diese Art von Simulationen zugeschnitten ist. Eine solche neuromorphe Beschleuniger-Architektur könnte dann idealerweise angekoppelt werden an die Jülicher Supercomputing-Infrastruktur. Man redet hier über einen großen Zeithorizont von 15 bis 20 Jahren.

Literatur

Arne Heittmann, Georgia Psychou, Guido Trensch, Charles E. Cox, Winfried W. Wilcke, Markus Diesmann and Tobias G. Noll (2022). Simulating the Cortical Microcircuit Significantly Faster Than Real Time on the IBM INC-3000 Neural Supercomputer, Front. Neurosci. , doi:10.3389/fnins.2021.728460

Zum Thema „Künstliche Intelligenz in der Medizin“ hat 1997 der Europarat die weltweit erste internationale Bioethikkonvention veröffentlicht, die vielen Mitgliedstaaten geholfen hat, ethische Standards in der Biomedizin zu formulieren. Auch ging es darum, die Kompatibilität dieser Normen mit denen der Europäischen Menschenrechtskonvention sicherzustellen. 2020 hat der Europarat dann einen strategischen Aktionsplan zu Menschenrechten und Technologien in der Biomedizin erstellt und will sich in den kommenden zwei Jahren intensiv mit Künstliche Intelligenz-Themen im Gesundheitswesen beschäftigen. Der britische Datenethik-Forscher Brent Mittelstadt von der Universität Oxford hat dazu einem Bericht erstellt. Darin wird vor möglichen Auswirkungen von Künstlicher Intelligenz auf Menschen- und Patientenrechte gewarnt, etwa im Hinblick auf Ungleichheiten beim Zugang zu hochwertiger Gesundheitsversorgung oder vor sozialen Vorurteilen, die in die Entwicklung von Künstlichen Intelligenz-Systemen einfließen. Mittelstadt fordert mehr Transparenz bei der Entwicklung und beim Einsatz solcher Technologien im Verhältnis zu medizinischen Fachkräften und Patienten sowie den Schutz der Vertraulichkeit von Patientendaten. Weiterhin schildert der Bericht mögliche Folgen der Künstlichen Intelligenz im Hinblick auf den Verlust von Kompetenzen bei Gesundheitsfachkräften und bei der Verlagerung von Verantwortung. Allerdings kann Künstliche Intelligenz Ärzte darin unterstützen, noch effektiver und effizienter zu arbeiten als bisher.

Literatur

Stangl, W. (2022, 16. Juni). Künstliche Intelligenz in der Medizin. Stangl notiert ….

https:// notiert.stangl-taller.at/allgemein/kuenstliche-intelligenz-in-der-medizin/

Es wird allgemein angenommen, dass die Anwendung anthropomorpher Designmerkmale die Mensch-Roboter-Interaktion erleichtert, wobei eine beträchtliche Anzahl von Studienergebnissen jedoch in die entgegengesetzte Richtung deutet. Es gibt derzeit keine umfassende gemeinsame Grundlage für die Umstände, unter denen Anthropomorphismus die Interaktion mit Robotern fördert. Roesler et al. 2021) wollen mit dieser Meta-Analyse diese Lücke schließen. Insgesamt wurden 4856 Abstracts gescannt, wobei nach einer umfangreichen Auswertung 78 Studien mit rund 6000 Teilnehmern und 187 Effektgrößen in diese Meta-Analyse aufgenommen wurden. Die Mehrzahl der Studien befasste sich mit Auswirkungen auf die Wahrnehmung von Robotern. Darüber hinaus wurden aber auch Effekte auf einstellungsbezogene, affektive und verhaltensbezogene Aspekte untersucht. Insgesamt wurde eine mittlere positive Effektgröße gefunden, was auf einen positiven Effekt von anthropomorphen Designmerkmalen auf menschenbezogene Ergebnisse hinweist. Eine genauere Betrachtung der untersten Variablenebene ergab jedoch keinen positiven Effekt auf die wahrgenommene Sicherheit, das Einfühlungsvermögen und die Aufgabenleistung. Darüber hinaus deutet die Analyse darauf hin, dass positive Effekte von Anthropomorphismus stark von verschiedenen Moderatoren abhängen, denn etwa war der Anthropomorphismus im Gegensatz zu anderen Anwendungsbereichen eine ständige Erleichterung der sozialen Mensch-Roboter-Interaktion.

Insgesamt zeigte sich durchaus ein positiver Effekt von Anthropomorphismus auf die Wahrnehmung, die Einstellungen, und die affektiven und verhaltensbezogenen Reaktionen von Menschen in ihrer Interaktion mit Robotern, doch spezifischere Teilanalysen des Datensatzes zeigten aber, dass Anthropomorphismus bei Robotern keineswegs ein Universalmittel zur Förderung der Mensch-Roboter-Interaktion darstellt. So konnten keine Belege für positive Effekte von Anthropomorphismus auf die wahrgenommene Sicherheit von Robotern und die Aufgabenleistung bei gemeinsamen Aufgaben gefunden werden, die gerade in Bereichen, in denen Roboter als Werkzeuge benutzt werden, bedeutsam sind, zum Beispiel in Service oder Industrie. Besonders in Bezug auf das Aussehen und die Beschreibung von Robotern haben auch eigene Untersuchungen der ForscherInnen gezeigt, dass eine Ausstattung von Robotern mit menschenähnlichen Merkmalen in aufgabenbezogenen und industriellen Bereichen auch negative Konsequenzen haben kann. Dort kann Anthropomorphismus etwa den Werkzeugcharakter von Robotern verschleiern und damit zu einem geringeren Vertrauen führen.

In Bereichen, in denen Roboter für die Erledigung kollektiver Aufgaben benutzt werden, werden anthropomorphen Robotern als „intelligent“ oder „sympathisch“ erlebt, was aber nicht Hand in Hand mit einer tatsächlich besseren Leistung in der Zusammenarbeit mit Robotern gehen muss. Eine bedeutende Rolle spielt auch die Art der Implementierung anthropomorpher Elemente, denn diese Merkmale zeigen vor allem dann positive Effekte, wenn sie möglichst sinnhaft auf die Aufgabe bezogen gestaltet werden, etwa eine Augenbewegung, die signalisiert, was der Roboter gerade verarbeitet. Das ist besonders für die Gestaltung von Robotern für industrielle Anwendungen und den Servicebereich interessant, denn dort wird die Bedeutung von oberflächlicher Anthropomorphisierung aktuell scheinbar noch überschätzt.

Die Ergebnisse dieser Analyse geben einigen Aufschluss darüber, wie Designmerkmale genutzt werden können, um die Qualität sie Mensch-Roboter-Interaktion zu verbessern.

Literatur

Roesler, E., Manzey, D. & Onnasch, L. (2021). A meta-analysis on the effectiveness of anthropomorphism in human-robot interaction. Science Robotics, doi: 10.1126/scirobotics.abj5425.