Die japanische Firma Groove X verdient mit dem Roboter Lovot erfolgreich Geld, indem sie auf emotionale Bedürfnisse der Menschen abzielt. Lovot, ein kleiner, kuscheliger Roboter, der auf Wärme und Aufmerksamkeit reagiert, wurde seit 2018 etwa 14.000 Mal verkauft. Mit einem Preis von 3000 Euro pro Stück und monatlichen Servicegebühren von 70 Euro bleibt Lovot wirtschaftlich erfolgreich, da 90 Prozent der Kunden ihn auch nach drei Jahren noch nutzen.

Lovot gehört zur Kategorie der „haptischen Wesen“, die durch ihre einfache Technik, aber hohe emotionale Bindung auffallen. Diese Roboter bieten keine komplexen Interaktionen, sondern schaffen durch ihre Sensoren eine physische Erfahrung, die Menschen emotional anspricht. Vorläufer dieser Bewegung waren Roboter wie die Roboter-Robbe Paro. Andere Beispiele sind das schwanzwedelnde Kissen Qoobo und der mechanische Hamster Moflin.

Der Gründer von Groove X, Kaname Hayashi, erkannte während seiner Karriere bei Toyota und Softbank die Marktlücke für einfachere, emotional ansprechende Roboter. Seine Erfahrung mit dem humanoiden Roboter Pepper, der kommerziell nicht erfolgreich war, führte ihn zu der Einsicht, dass die Erwartungen der Menschen an Roboter oft zu hoch sind.

Hayashi sieht den aktuellen Hype um humanoide Roboter kritisch und glaubt, dass echte Durchbrüche noch Zeit benötigen. Bis dahin setzen er und andere auf Roboter, die emotionale Unterstützung bieten, wie Lovot. Die Hauptkäufergruppe sind Frauen zwischen 40 und 50 Jahren, die den Roboter als Ersatz für Haustiere sehen. Hayashi plant, Roboter mit KI zu entwickeln, die als persönliche Coaches fungieren und den Menschen helfen sollen, in einer sich schnell verändernden Welt glücklich zu bleiben und weiterzulernen.

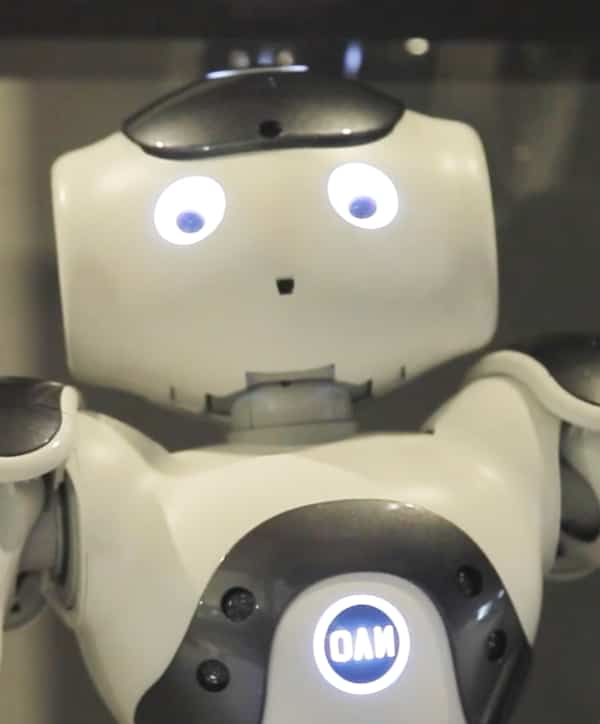

Kühne et al. (2024) untersuchten in einer Studie die Auswirkungen des Berliner Dialekts auf die wahrgenommene Vertrauenswürdigkeit und Kompetenz eines Roboters. Deutsche Muttersprachler sahen sich ein Online-Video mit einem NAO-Roboter, der entweder im Berliner Dialekt oder in Standarddeutsch sprach, und bewerteten seine Vertrauenswürdigkeit und Kompetenz. Dabei zeigte sich ein positiver Zusammenhang zwischen den selbst berichteten Berliner Dialektkenntnissen und Vertrauenswürdigkeit des im Dialekt-sprechenden Roboters. Bei der Analyse der demografischen Faktoren gab es einen positiven Zusammenhang zwischen den Dialektkenntnissen der Teilnehmer, der Dialektleistung und deren Bewertung der Kompetenz des Roboters für den Standard-Deutschsprachigen Roboter. Auch das Alter der Teilnehmer, das Geschlecht, die Aufenthaltsdauer in Berlin beeinflussten die Bewertungen, d. h., die Kompetenz des Roboters kann seine Vertrauenswürdigkeit positiv voraussagen. Menschen neigten offenbar dazu, Roboter zu bevorzugen, die ihnen irgendwie ähnlich sind.

Kühne et al. (2024) untersuchten in einer Studie die Auswirkungen des Berliner Dialekts auf die wahrgenommene Vertrauenswürdigkeit und Kompetenz eines Roboters. Deutsche Muttersprachler sahen sich ein Online-Video mit einem NAO-Roboter, der entweder im Berliner Dialekt oder in Standarddeutsch sprach, und bewerteten seine Vertrauenswürdigkeit und Kompetenz. Dabei zeigte sich ein positiver Zusammenhang zwischen den selbst berichteten Berliner Dialektkenntnissen und Vertrauenswürdigkeit des im Dialekt-sprechenden Roboters. Bei der Analyse der demografischen Faktoren gab es einen positiven Zusammenhang zwischen den Dialektkenntnissen der Teilnehmer, der Dialektleistung und deren Bewertung der Kompetenz des Roboters für den Standard-Deutschsprachigen Roboter. Auch das Alter der Teilnehmer, das Geschlecht, die Aufenthaltsdauer in Berlin beeinflussten die Bewertungen, d. h., die Kompetenz des Roboters kann seine Vertrauenswürdigkeit positiv voraussagen. Menschen neigten offenbar dazu, Roboter zu bevorzugen, die ihnen irgendwie ähnlich sind. Ästhetik und Wahrnehmung: Weiße Roboter wirken oft sauberer und moderner, was in bestimmten Umgebungen wie Krankenhäusern oder Hotels wichtig sein kann, wo ein sauberes Erscheinungsbild erwünscht ist.

Ästhetik und Wahrnehmung: Weiße Roboter wirken oft sauberer und moderner, was in bestimmten Umgebungen wie Krankenhäusern oder Hotels wichtig sein kann, wo ein sauberes Erscheinungsbild erwünscht ist.