Es war ein sonniger Tag im Frühling, als Emma beschloss, ihren langjährigen Freund David zu besuchen. Sie hatten sich in der Highschool kennengelernt und seitdem eine unzertrennliche Freundschaft aufgebaut. Aber in den letzten Jahren hatten sie sich aufgrund von Arbeit und anderen Verpflichtungen kaum noch gesehen. Emma hatte beschlossen, dass es an der Zeit war, dies zu ändern.

Als sie bei Davids Haus ankam, war sie überrascht, dass er nicht da war. Sie rief ihn an, aber er antwortete nicht. Sie hinterließ eine Nachricht und beschloss, eine Weile auf der Veranda zu warten, in der Hoffnung, dass er bald zurückkehren würde.

Während sie auf ihn wartete, dachte Emma über ihre Freundschaft nach. Sie erinnerte sich an all die guten Zeiten, die sie miteinander verbracht hatten, und daran, wie viel sie füreinander da gewesen waren. Aber in den letzten Monaten hatte sie das Gefühl, dass ihre Freundschaft sich verändert hatte. David schien sich zurückzuziehen und nicht mehr so interessiert zu sein wie früher.

Als David schließlich nach Hause kam, war er überrascht und glücklich, Emma zu sehen. Sie umarmten sich herzlich und setzten sich dann auf die Veranda, um zu plaudern.

„Ich freue mich so sehr, dass du hier bist“, sagte David und lächelte sie an.

„Ich freue mich auch“, erwiderte Emma. „Aber ich muss sagen, ich habe das Gefühl, dass wir uns in letzter Zeit ein wenig entfremdet haben.“

David seufzte und lehnte sich zurück. „Ja, ich weiß. Es tut mir leid, dass ich in letzter Zeit so beschäftigt war. Aber ich habe versucht, die Dinge wieder in Ordnung zu bringen. Ich möchte unsere Freundschaft nicht aufgeben.“

Emma lächelte und legte eine Hand auf seine Schulter. „Ich möchte das auch nicht. Aber ich habe das Gefühl, dass wir uns anstrengen müssen, um die Dinge wieder in Gang zu bringen.“

David nickte zustimmend. „Ja, das stimmt. Aber ich denke, dass wir es schaffen können. Wir haben eine starke Freundschaft, trotz allem, was passiert ist.“

Emma nickte zustimmend und sie sprachen über all die Dinge, die sie in letzter Zeit beschäftigt hatten. Sie lachten und erinnerten sich an alte Geschichten, und Emma war glücklich zu spüren, dass ihre Freundschaft immer noch so stark war wie früher.

Als der Abend hereinbrach, sagte Emma zu David: „Ich bin so froh, dass wir uns heute getroffen haben. Ich denke, wir haben einen wichtigen Schritt gemacht, um unsere Freundschaft wiederherzustellen.“

David nickte zustimmend. „Ja, das denke ich auch. Aber es wird trotzdem eine Weile dauern, bis alles wieder so ist wie früher. Wir müssen uns beide anstrengen.“

Emma lächelte und stand auf, um zu gehen. „Ich weiß. Aber ich bin bereit, daran zu arbeiten. Ich möchte, dass unsere Freundschaft wieder so stark wird wie früher, trotz allem, was passiert ist.“

David stand auf und umarmte sie erneut. „Ich auch. Wir schaffen das!“

Die nächsten Wochen verliefen für Emma und David anders als gewöhnlich. Sie trafen sich häufiger als zuvor, sprachen über ihre Probleme und Träume und erneuerten ihre alte Freundschaft. Sie besuchten gemeinsam Ausstellungen, gingen ins Kino und trafen sich zum Essen. Es war, als ob sie versuchten, all die verpasste Zeit wieder aufzuholen.

Eines Tages lud David Emma zu einer Wanderung in den Bergen ein. Sie hatten schon lange nicht mehr gemeinsam Zeit in der Natur verbracht und Emma war begeistert von der Idee. Sie trafen sich frühmorgens und fuhren zusammen in die Berge.

Als sie den Gipfel erreichten, waren beide beeindruckt von der Aussicht. Es war ein klarer Tag und sie konnten bis zum Horizont sehen. David legte seine Hand auf Emmas Schulter und sagte: „Ich bin so dankbar für unsere Freundschaft. Wir haben so viel gemeinsam erlebt und ich bin froh, dass wir trotz aller Schwierigkeiten immer noch hier stehen.“

Emma lächelte und erwiderte: „Ich auch. Es war eine Herausforderung, aber wir haben es gemeinsam geschafft.“

Sie saßen eine Weile schweigend da und genossen die Aussicht. Dann fragte Emma: „Was denkst du, was als Nächstes passieren wird? Wird unsere Freundschaft noch stärker werden?“

David schaute sie an und lächelte. „Ich denke schon. Wir haben bewiesen, dass wir auch schwierige Zeiten gemeinsam durchstehen können. Ich denke, dass wir noch enger zusammenwachsen werden.“

Emma lächelte zurück und sagte: „Ich freue mich darauf. Ich bin dankbar, dass wir trotz allem immer noch so gute Freunde sind.“

David nickte zustimmend und sie saßen noch eine Weile schweigend da, bevor sie sich entschieden, den Berg hinunterzusteigen. Es war ein langer Weg zurück, aber sie gingen gemeinsam und genossen die Zeit miteinander.

Am Ende des Tages verabschiedeten sie sich mit einer Umarmung.

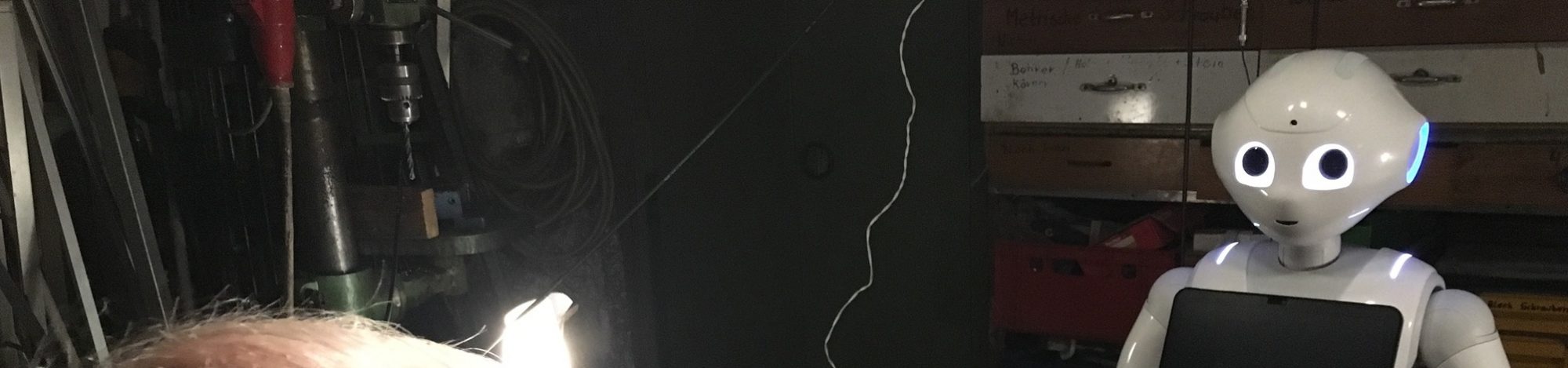

Vom 13. bis zum 15. März, steht der Gebetsroboter CelesTE täglich von 10 bis 16 Uhr in den Räumen von CampusSegen, Basis Bochum, der Hochschulseelsorge des Bistums Essen im Universitätsforum UFO im Unicenter, Querenburger Höhe 283, 44801 Bochum.

Vom 13. bis zum 15. März, steht der Gebetsroboter CelesTE täglich von 10 bis 16 Uhr in den Räumen von CampusSegen, Basis Bochum, der Hochschulseelsorge des Bistums Essen im Universitätsforum UFO im Unicenter, Querenburger Höhe 283, 44801 Bochum.